Physikinformierte Neuronale Netze für den Betonbau

Autor: Rafael Bischof

Sprache: Englisch

Kurzfassung

Neuronale Netze sind universelle Funktionsapproximatoren und haben beein-druckende Ergebnisse bei einer Vielzahl unterschiedlicher Aufgaben gezeigt, insbesondere in Problemen mit unstrukturierten Daten und einer grossen Menge an Trainingsdaten. Physikinformierte Neuronale Netze (PINN) nutzen bekannte physikalische Gesetze, oft in Form von partiellen Differentialgleichungen (PDG), indem sie diese in ihre Verlustfunktion einbeziehen. Dieser Prior erleichtert den Trainingsprozess, sodass das Modell schnell konvergiert, selbst wenn nur wenige oder gar keine Trainingsbeispiele verfügbar sind. Ihre Kontinuität, Flexibilität und die Möglichkeit zur Vorhersage der Lösung einer gegebenen PDG in einem einzigen Vorwärts-schritt macht sie zu einer interessanten Alternative gegenüber etablierten numerischen Techniken wie der Finite-Elemente-Methode.

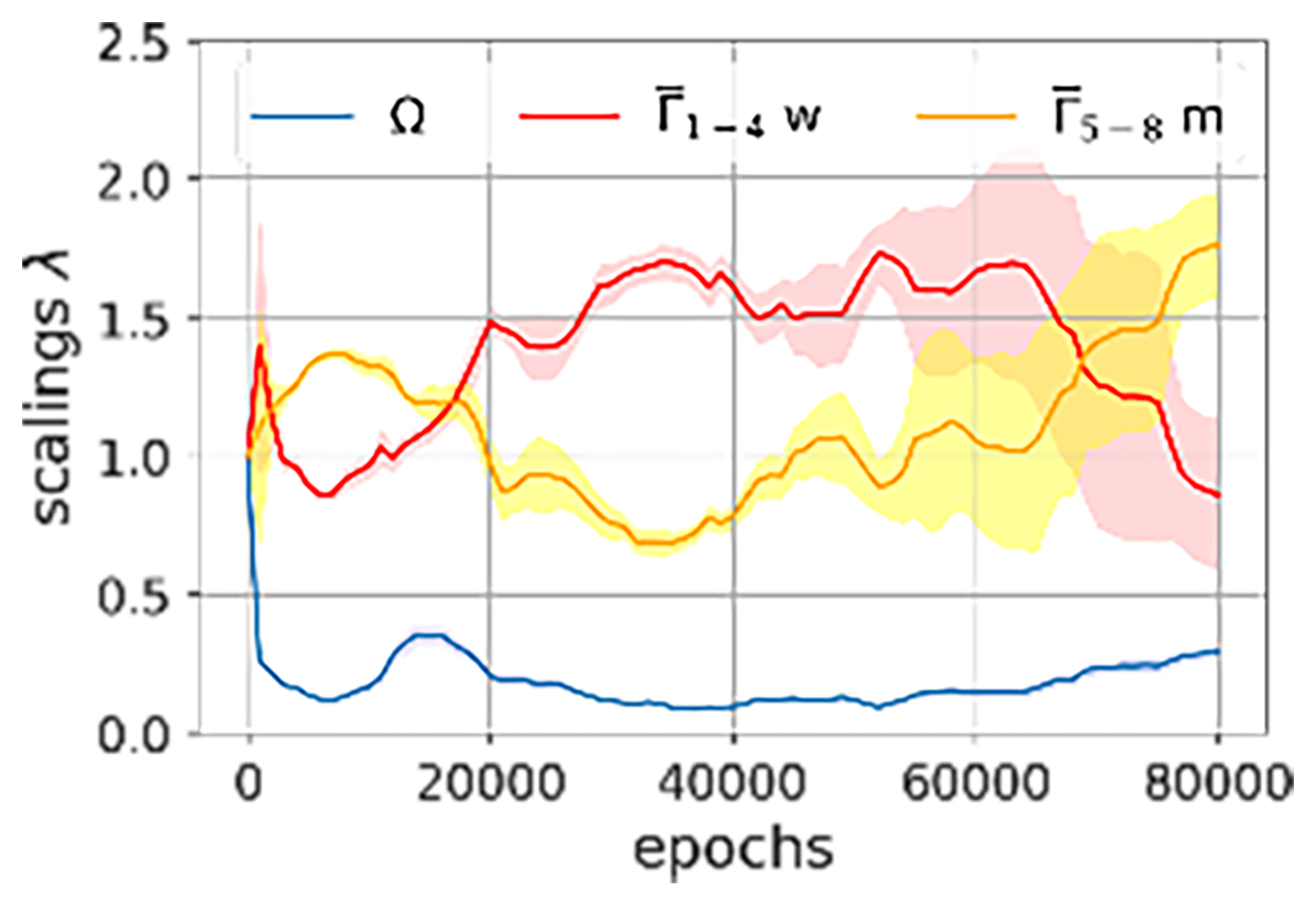

Diese Arbeit beschäftigt sich damit, PINNs zuverlässiger zu machen und die Wirksamkeit verschiedener Erweiterungen von Vanilla-PINNs zu untersuchen. In einem ersten Schritt untersuchen wir das Problem der Gradienten-pathologien, die aufgrund von Termen mit unterschiedlichen Masseinheiten und der damit verbundenen unterschiedlich starken Gradienten entstehen. Zu diesem Zweck vergleichen wir die Leistung von drei adaptiven Verlustausgleichs-algorithmen: Learning Rate Annealing, GradNorm und SoftAdapt. Darüber hinaus präsentieren wir unsere eigene Version der oben genannten Methoden: Relative Loss Balancing with Random Lookbacks (ReLoBRaLo). Um ihre Verallgemeinerbarkeit zu beurteilen, testen wir die vier Algorithmen an drei Benchmark-Problemen für PINNs: den Helmholtz-, Burgers- und Kirchhoff-PDG. Die Ergebnisse zeigen, dass die Skalierungsheuristiken die Basislinie mit manuell ausgewählten Skalierungen durchweg übertreffen, wobei unsere Methode insbesondere auf der Kirchhoff-Gleichung besonders effektiv ist. Darüber hinaus zeigen wir, dass die von ReLoBRaLo generierten Skalierungen wertvolle Einblicke in den Trainingsprozess geben und für fundierte Entscheidungen zur Verbesserung des Frameworks verwendet werden können.

In einem zweiten Schritt führen wir eine umfangreiche Parameterstudie zur Kirchhoff- schen Plattenbiegegleichung durch, in der wir verschiedene Netzwerkarchitekturen, Aktivie-rungsfunktionen und Abtasttechniken testen. Dier Ergebnisse werden neben unter Gesichtspunkten des Machine Learning aber auch Bauingenieurwesen bewertet. Dabei werden Hyperparameter und Erweiterungen erarbeitet, welche die Genauigkeit des PINNs-Modells verbessern. Bei vielen PDG-Problemen sind unsere Modelle in der Lage, vielversprechende Ergebnisse zu erzielen. Wir identifizieren jedoch auch wichtige Einschränkungen und Fehlermodi, die behoben werden müssen, bevor PINNs in realen Anwendungen verwendet werden können.

PINNs werden derzeit am häufigsten als sogenannte Repräsentationsnetzwerke verwen-det. Somit repräsentieren sie parametrisierte PDG mit fixen Parametern, Rand- und Anfangs-bedingungen. Jede geringfügige Änderung dieser Parameter erzwingt somit aber ein erneutes rechenintensives Trainieren des Netzwerks. Daher werden im letzten Schritt dieser Arbeit Hypernetzwerke vorgeschlagen. Diese werden verwendet, um eine Einbettung von Kontext-variablen in Parameter eines anderen, Hauptnetz zu übersetzen. Im Kontext von PDG empfängt ein solches Hypernetz die Randbedingungen sowie PDG-Parameter als Eingabe und generiert die Parameter für das entsprechende PINN. Die An-wendbarkeit von Hypernetzen und deren gute Approximationsergebnisse werden anhand der Helmholtz- und Kirchhoff-PDG dargestellt.